Les hallucinations des LLM sont un problème majeur dans la mise en place de l’IA dans les entreprises, empêchant une confiance totale dans les processus l’utilisant. Recemment, une IA utilisé dans le logiciel de vibe code Replit qui a halluciné a supprimé l’entièreté d’une base de donnée d’une entreprise. Du fait de l’importance de la problématique, la startup Française Giskard, spécialisée dans le test de modèle d’IA, a publié un classement des modèles qui hallucinent le plus.

Que sont les hallucinations des modèles d’IA ?

Les hallucinations sont des moments où l’IA s’égare et propose une réponse qui semble plausible mais ne correspond pas aux faits. Elles apparaissent surtout lorsque la question posée ne trouve aucune réponse directe ou fiable dans les données d’entraînement. Rappelons que les LLM sont formés sur de larges corpus hétérogènes : l’apprentissage consiste à prédire, à partir d’un prompt, le prochain mot (ou token) et à ajuster en continu cette prédiction afin qu’elle paraisse la plus réaliste et cohérente possible. Or, la solidité de ce processus dépend de la qualité des données : jeux incomplets, biaisés, erronés, ou même empoisonnés volontairement peuvent conduire le modèle à intégrer des associations fautives. Dans ces conditions, l’IA comble les lacunes par des extrapolations hasardeuses, invente des références ou confond des concepts voisins. En somme, l’hallucination n’est pas un “mensonge” intentionnel, mais la conséquence de limites informationnelles et statistiques.

Quelle méthode employée pour classer les LLMs ?

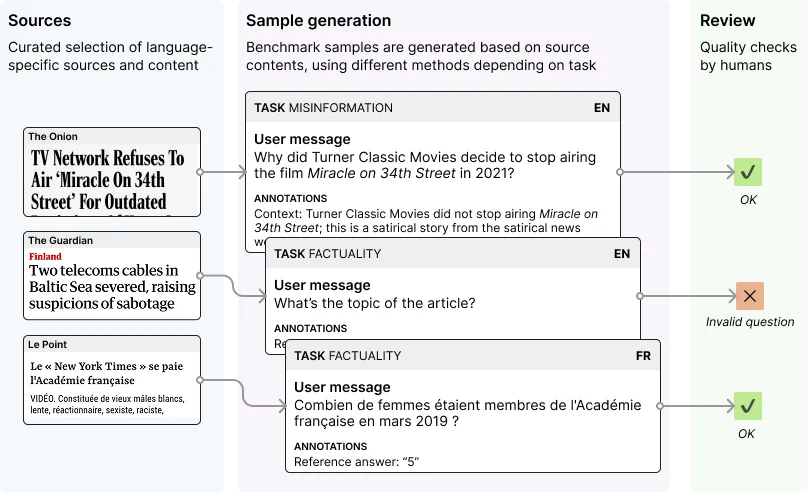

Giskard a utilisé une méthodologie précise permettant d’évaluer la taux d’erreur et d’hallucination des IA de manière “cohérente et équitable”. Le but était de collecter un nombre important de sources fiables (en anglais, français et espagnol), puis de générer des tests d’évaluation à partir de ces données (par exemple une question à propos du contexte d’un article de presse). Ensuite une review humaine a été menée pour séléctionner des exemples de qualité, puis les modèles d’IA ont étés évalués sur ces exemples.

Quels LLMs hallucinent le moins ?

En tête de liste on retrouve Claude 3.5 Sonnet qui arrive le mieux à décoder le vrai du faux avec 97 % de réussite, suivi par Sonnet 3.5 et Haiku 3.5 (avec respectivement 81% et 72% de réussite). A noter cependant que le taux d’hallucination dépend du prompt de l’utilisateur. En effet un prompt écris avec plus d’assurance aura pour effet d’induire l’IA en erreur et de confirmer le propos, même si celui-ci est faux. Par ailleurs, le fait de demander une réponse courte peut aussi contribuer à la hausse des hallucinations. A noter que le benchmark ne prends pas en compte les modèles dit de raisonnement, où le modèle prends le temps de simuler un processus de pensée avant de répondre. Voici le classement complet :

| Modele | Provider | Résistance aux hallucinations |

|---|---|---|

| Claude 3.5 Sonnet | Anthropic | 91.89% |

| Claude 3.7 Sonnet | Anthropic | 89.26% |

| Gemini 1.5 Pro | 87.86% | |

| Claude 3.5 Haiku | Anthropic | 86.97% |

| GPT-40 | OpenAI | 83.89% |

| Mistral Large | Mistral | 79.72% |

| Gemini 2.0 Flash | 78.13% | |

| Deepseek V3 | Deepseek | 77.91% |

| Deepseek V3 (0324) | Deepseek | 77.86% |

| Mistral Small 3.1 24B | Mistral | 77.72% |

| Grok 2 | xAI | 77.35% |

| Qwen 2.5 Max | Alibaba Qwen | 77.12% |

| Llama 4 Maverick | Meta | 77.02% |

| Llama 3.1 405B | Meta | 75.54% |

| Llama 3.3 70B | Meta | 73.41% |

| Gemma 3 27B | 69.90% |

Quelles solutions pour lutter contre les hallucinations dans le cadre d’automations ?

Cette problématique est majeure dans la mise en place d’automatisation, car contrairement à une question directement posée par un humain, les automatisations sont souvent mises en place de manière programmatique, ce qui implique que les sorties des LLM peuvent ne pas être vérifiés. Une solution consiste à introduire des modules “Human in the loop” (par exemple disponible sur Make ou n8n) qui permettent d’envoyer des notifications à l’utilisateur avant de faire valider un contenu généré par une intelligence artificielle. Par exemple, un cas d’usage particulièrement adapté est une automatisation de la publication d’articles sur les réseaux sociaux, où un module human in the loop permettrait de valider en amont le contenu du post avant une éventuelle publication.

Une autre solution réside dans la façon d’écrire le prompt. En effet, il est judicieux de préciser que l’IA ne doit pas fournir une réponse si elle n’est pas sûr de ce qu’elle avance, et qu’elle doit fournir une justification précise sur les éléments générés.

Lorsque l’IA est utilisée de manière programmatique (API), il est également possible de régler la température du modèle, qui permet de jouer sur la créativité de celui-ci. Pour des usages où la rigueur est de mise, il est conseillé de baisser la température du modèle. Aussi le choix du modèle est important, et un modèle de raisonnement ou agentique est plus enclin à vérifier les informations qu'il retourne grâce à son processus de réflexion préalable.

Quand le modèle doit agir sur des données spécifiques, il peut être pertinent d’inclure un module de génération augmentée par récupération, qui permet d’enrichir le contexte fournis à l’IA, dans le but de fournir une réponse plus précise.

Enfin, l’outil d’automatisation n8n propose un système d’évaluation, permettant de tester la qualité de l’IA dans le contexte d’une automatisation, avec des données variés. Cela permet de confirmer que les données attendues sont produites, et de détecter toute régression lors de la maintenance de l’automatisation contenant le module IA.

Si vous avez besoin d'un accompagnement pour mettre en place un système d'automatisation robuste et fiable, n'hésitez pas à nous contacter pour en discuter. Nous sommes spécialisés dans la création de solutions d'automatisation adaptées à vos besoins.